Аффилированные сайты — это ресурсы-клоны, созданные для монополизации первой страницы поисковой выдачи. Для людей, слабо ориентирующихся в тенденциях современного поиска, может показаться привлекательной идея сделать несколько копий сайта, немного вложиться в их раскрутку и приумножить целевой трафик. Но так не работает.

Продвижение аффилиатами — довольно архаичная манипуляция из арсенала черного SEO, с которой эффективно борются и в Google, и в «Яндексе». Даже если сайты запущены на разных доменах, имеют нешаблонный дизайн, наполнены уникальным (а, возможно, и полезным) контентом, но имеют одного владельца, продвигают одинаковый бренд или заточены под один и тот же интент (пользовательские потребности) — обвести поисковики вокруг пальца будет сложно. Алгоритмы быстро и точно идентифицируют аффилиаты и уберут их из поиска. Причем в бан может попасть основной ресурс, а в выдаче останется менее качественный клон.

Механика аффилиат-фильтров Google и Яндекса

Начать следует с того, что Google и Яндекс официально не используют понятие аффилиат, а санкции, накладываемые за манипуляции с дублями сайтов, по своей механике не совсем схожи с классическим фильтром. Тем не менее, название аффилиат-фильтр прочно закрепилось среди вебмастеров и сеошников, и его неофициальный статус нисколько не преуменьшает серьезности последствий.

В Яндексе аффилиаты идентифицируются алгоритмами (автоматически) или по жалобе пользователей, в роли которых, обычно, выступают внимательные конкуренты. Соответственно, санкции накладываются автоматом или ручным способом. Все клоны исключаются из выдачи или же сильно понижаются в ранжировании. В поиске остается только один ресурс, который алгоритмы посчитают наиболее релевантным (и совершенно не факт, что это будет основной сайт).

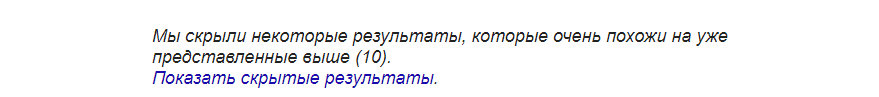

В выдаче Google аффилированные сайты попадают в дополнительный индекс — они не отображаются в основной выдаче, а доступны по ссылке «Показать скрытые результаты». Это не совсем корректно называть фильтром в привычном понимании, но последствия в данном случае 100% аналогичные. Сайт полностью теряет поисковый трафик из Google и становится, по сути, бесполезным.

Какие сайты не считаются аффилиатами

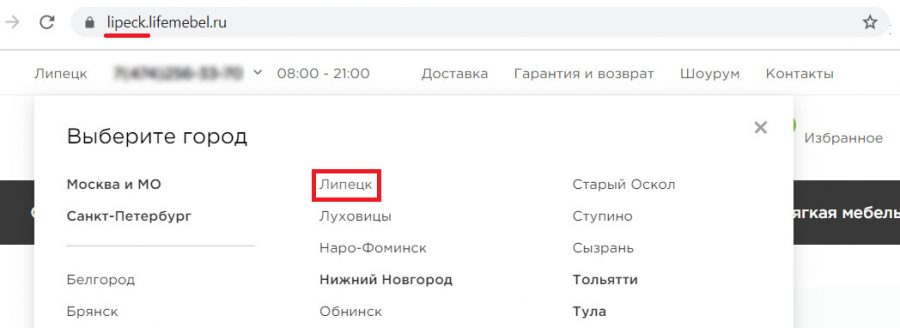

В первую очередь, речь идет о версиях сайта на поддоменах. Это самая безопасная стратегия регионального продвижения — когда у основного ресурса есть несколько локализованных версий. Но и здесь не все так просто. Сам по себе поддомен не исключает на 100% санкций за аффилированность. Чтобы обезопасить ресурс от проблем, необходимо выполнить ряд мер:

1. Прописать регион для каждого поддомена в Вебмастере.

2. Зарегистрировать каждый региональный филиал в Яндекс.Справочнике и Google Мой бизнес.

3. Локализовать Title — прописать для каждой страницы название нужного города.

4. Добавить пользовательскую информацию, которая уточнит локализацию поддомена — адрес филиала, региональный телефон, способы доставки в конкретном городе и т.д.

Вам также может быть интересно: Локальное SEO. Как продвигать бизнес в региональной выдаче

Аффилиатами также не считаются сайты, созданные под разные векторы деятельности одной компании. Например, это может быть корпоративный ресурс и еCommerce-сайт одной и той же организации. Оба проекта могут иметь разные названия, но общий IP-адрес, одни и те же контактные данные и другие признаки аффилированности — при этом не будут считаться клонами. Но следует понимать, что безопасный сценарий возможен только в том случае, если оба сайта имеют четко разграниченную ЦА и продвигаются по разным кластерам поисковых запросов.

Когда дубль сайта нужен по объективным причинам

Манипуляции с аффилиатами — рискованное занятие, от которого давно отказались даже серые сеошники. Но бывают ситуации, когда дубли сайтов нужны по весьма обоснованным причинам. Здесь речь уже не идет о спекуляциях с выдачей. Например, магазин или компания может иметь региональные представительства, и по каким-то причинам для каждого филиала целесообразно создавать отдельный сайт, а не использовать региональные поддомены. В серой зоне также оказываются организации, имеющие группу сайтов, созданные под разные цели или, например, отдельные направления деятельности компании. Если для поисковиков интент каждого из таких сайтов очерчен недостаточно четко — возможны проблемы.

Вам также может быть интересно: Неполные дубли. Как уникализировать однотипные карточки товаров

Клон сайта все же нужен. Как минимизировать вероятность фильтра

Если вы не планировали заниматься черным SEO, и дублирующие версии сайта вам нужны по объективным причинам — продвигаться белыми способами вполне реально. Здесь важно сделать все правильно и перестраховаться всеми возможными вариантами. Вот ряд базовых рекомендаций, которые уменьшат вероятность санкций за аффилированность.

Используйте разные названия для сайтов, которые не содержат одинаковых слов в доменном имени. Еще лучше, если проекты и вовсе будут зарегистрированы в разных доменных зонах.

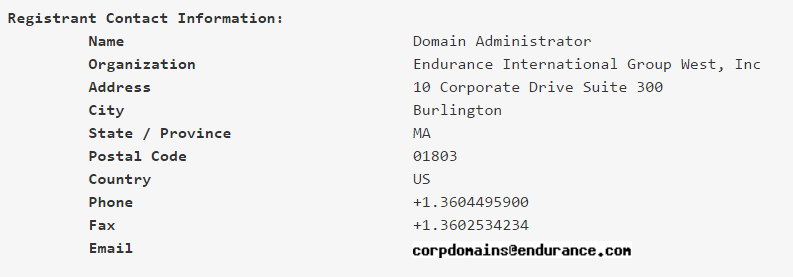

Скрывайте данные о владельце домена. Информацию о доменном имени и его администраторе легко получить через Whois-сервисы, поэтому публичный доступ к таким данным нужно ограничить. Большинство регистраторов по умолчанию скрывает эти сведения, но перестраховаться и проверить какая информация присутствует в публичном доступе будет не лишним.

Учитывайте особенности конкретной доменной зоны. Существуют домены, на которых нельзя скрыть публичный доступ к информации об администраторе. Например, таковы условия национального законодательства в зоне .kz (Казахстан), .ch (Швейцария), .in (Индия) и некоторых других странах.

Указывайте уникальные контактные данные на разных сайтах. С адресом в этом случае сложно, поэтому его лучше не прописывать вовсе. А вот телефон, email, мессенджеры — это то, что нужно не полениться завести (и указать) для каждого сайта отдельно.

Не давайте ссылки на общие аккаунты в соцсетях. Это один из факторов, который учитывается поисковиками. Соцсети нужно либо вести отдельно, либо не давать на них ссылку вовсе. Так безопаснее.

Используйте разные учетные записи в сервисах поисковиков. Это еще одно принципиально важное условие. Каждый ресурс должен быть привязан к отдельному аккаунту в Яндекс.Метрике и Google Analytics, а также Вебмастере и Search Console.

Размещайте сайты на разных хостингах. Да, это весьма неудобно и создает лишнюю головную боль при администрировании, но так надежней. Если вы все же решили хоститься у одного провайдера — обратите внимание, чтобы сайты имели уникальные IP-адреса. Это критически важный момент.

Избегайте шаблонной организации сайтов. Оптимальный вариант — запустить все сайты на разных движках. Конечно, такую увертку может позволить себе далеко не каждый, поэтому действуйте более доступными способами. Применяйте разные темы и шаблоны. Откажитесь от одинаковой структуры разделов. Используйте разные принципы организации URL. Если есть возможность, откажитесь от одних и тех же плагинов на сайтах.

Размещайте уникальный контент. Думаем, какие-либо комментарии здесь излишни. Дублированный контент и совпадение контактной информации — два основных признака, по которым алгоритмы быстро выявляют аффилированные сайты.

Используйте разные схемы линкбилдинга. Не связывайте свои сайты перекрестными ссылками. При наращивании внешнего ссылочного профиля, задействуйте разных доноров — не ссылайтесь на сеть своих сайтов с одних и тех же площадок.

Вам также может быть интересно: Как проверять ссылочных доноров? Критерии профессионального отбора

Оптимизируйте сайты под разные кластеры запросов. На ресурсы одной и той же тематики и продвигающиеся по идентичному набору ключей довольно быстро обратят внимание поисковые алгоритмы. Самое лучшее, что можно сделать в этой ситуации — выделить из семантического ядра главные кластеры ключей и распределить их между разными сайтами. Если вы все же решили оптимизировать сайты под идентичную группу запросов — обязательно разносите ресурсы по разным IP-адресам.

Уникализируйте Title (и другие метатеги). Это важная деталь, которая часто ускользает из поля зрения оптимизаторов. Генерация метатегов по общему шаблону приведет к тому, что все сниппеты в поисковой выдаче будут выглядит одинаково. Аффилированность сайтов станет видна невооруженным взглядом — для пользователей и, разумеется, для поисковиков.

Регистрируйте сайты с интервалом во времени. Дата регистрации доменов — это открытая информация, которую легко узнать через общедоступные онлайн-сервисы. Группа однотипных сайтов, зарегистрированных в один и тот же день, сразу выдает их аффилированность.

Для аффилированных интернет-магазинов помимо указанных выше рекомендаций важно по-разному группировать и каталогизировать товары. Также следует избегать полной идентичности прайс-листа — цены важный фактор ранжирования в eCommerce, который всегда на особом контроле у поисковых алгоритмов. Следите за тем, чтобы на разных сайтах стояли уникальные описания товаров и по возможности фото.

Важно понимать, что даже такой серьезный пул работ по конспирации не дает 100% защиты от санкций. Дамоклов меч аффилиат-фильтра всегда будет нависать над сетью ваших ресурсов. Поэтому изначально вдумчиво просчитайте рентабельность и учитывайте все вероятные риски. На основе этого принимайте решение о целесообразности многосайтовой стратегии продвижения.

Само собой, есть серьезные риски. Но тут еще как посмотреть... Риск при продвижении сайта есть всегда. Даже самый классный и правильно сделанный сайт может попасть под фильтры Яндекса или Гугла. А несколько сайтов, продвигаемых по разным схемам и с помощью разных технологий, резко уменьшают риск и делают поток клиентов из Интернета более стабильным, а прибыль больше. Если все делать правильно и строго соблюдать все, что написано в статье и еще добавить некоторые моменты, то все будет ок.