Манипуляции в выдаче: миф или реально работает?

Самые популярные манипуляции в SEO в 2025 году.

Манипуляции в SEO — тема горячая… Много споров среди специалистов и владельцев сайтов. Почему так? Всё началось с того, что традиционные методы оптимизации не всегда давали быстрые результаты, а алгоритмы поисковых систем постоянно менялись, привнося драйв нише, а сеошникам возможности для экспериментов. Так уж сложилось, что одни специалисты видят в серых методах способ обойти жёсткие правила и добиться более высоких позиций, другие считают их угрозой для качества поисковой выдачи и стабильности результатов.

Я — Михаил Мятов, опытный маркетолог и

Эффективная реклама с кешбэком 100%

Таргетированная реклама, которая работает на тебя!

Размещай ее в различных каналах, находи свою аудиторию и получай кешбэк 100% за запуск рекламы.

Подключи сервис от МегаФона, чтобы привлекать еще больше клиентов.

Какие методы действительно работают в 2025 году, а какие уже устарели? В этой статье мы подробно разберём самые популярные манипуляции в SEO. Я объясню, почему возникла такая ситуация, раскрою их эффективность и потенциальные риски, чтобы помочь вам принимать взвешенные решения в продвижении сайтов. Читайте дальше и узнайте, как использовать современные тактики без ущерба для качества и безопасности вашего ресурса.

Что считается манипуляциями в SEO

Определение манипуляций в SEO с точки зрения поисковых систем: это методы искусственного повышения позиций сайта в выдаче в обход алгоритмам. Нужно это, чтобы создать ложное соответствие запросам, даже если реальная ценность контента низкая.

Если перестараться, выдача будет переполнена сайтами с низким качеством информации, что снизит эффективность поиска и ухудшит пользовательский опыт. Чтобы этого не допустить, поисковые системы (далее ПС) постоянно совершенствуют алгоритмы, чтобы минимизировать механики искусственного продвижения и обеспечивать высокую релевантность результатов.

обеспечивать высокую релевантность результатов.

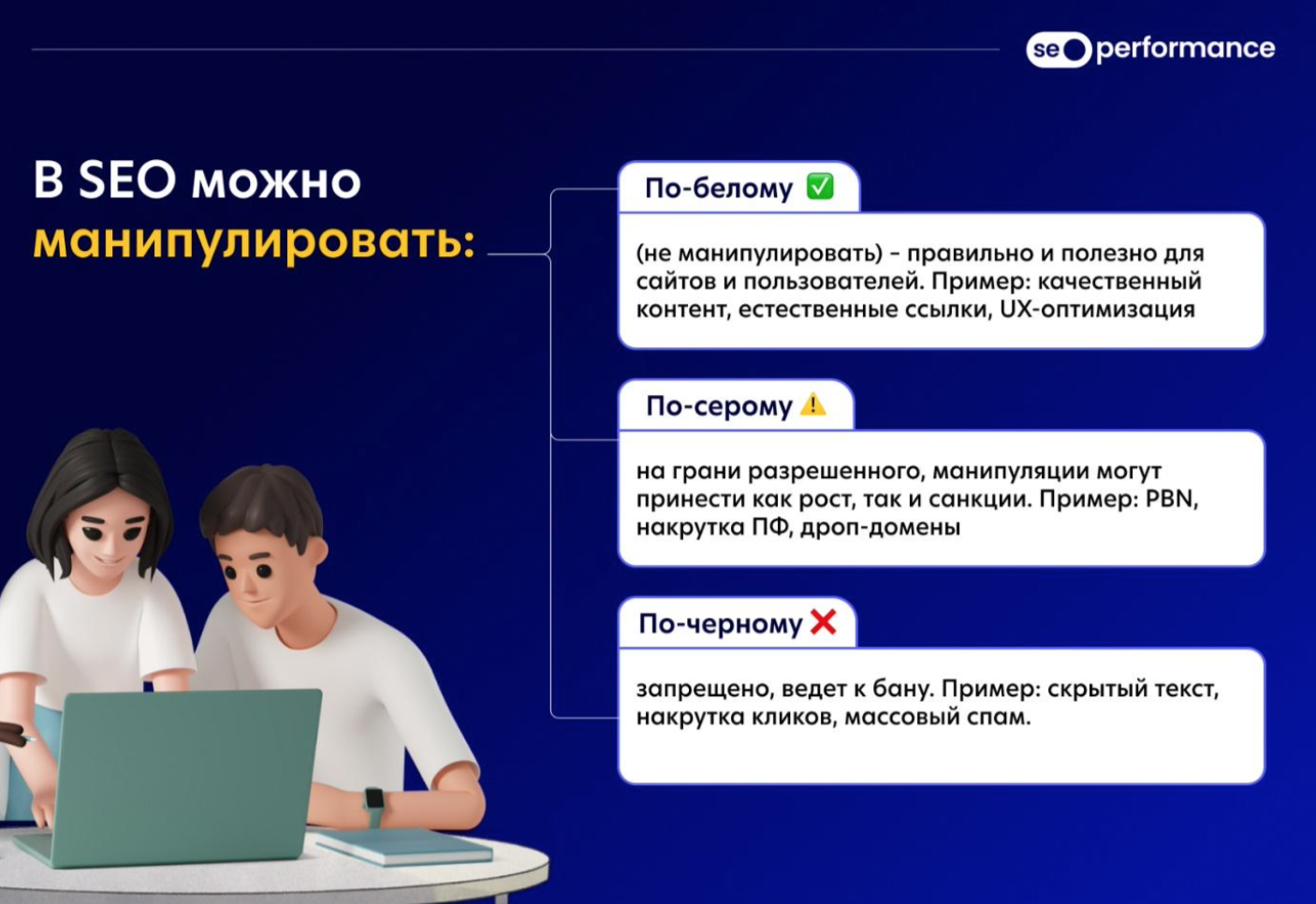

Основные категории манипуляций в SEO:

-

Белые методы соответствуют рекомендациям поисковых систем: публикация качественного контента, естественное привлечение ссылок, грамотная оптимизация UX.

-

Серые методы балансируют на грани разрешённого и запрещённого, включая использование PBN, скрытую покупку ссылок, искусственное улучшение поведенческих факторов.

-

Чёрные методы запрещены и могут привести к санкциям. Это накрутка кликов, скрытые тексты, агрессивная автоматическая генерация контента и другие схемы.

Почему Google и Яндекс борются с манипуляциями

Всё для пользователей: ПС стремятся обеспечивать пользователей качественным контентом, который помогает находить точные и полезные ответы на их запросы. Манипуляции же искажают выдачу, снижая её релевантность, что приводит к ухудшению пользовательского опыта, снижению доверия к ПС и созданию нечестной конкуренции. В противовес хитрецам поисковики разрабатывают сложные алгоритмы, которые выявляют попытки искусственного влияния на ранжирование.

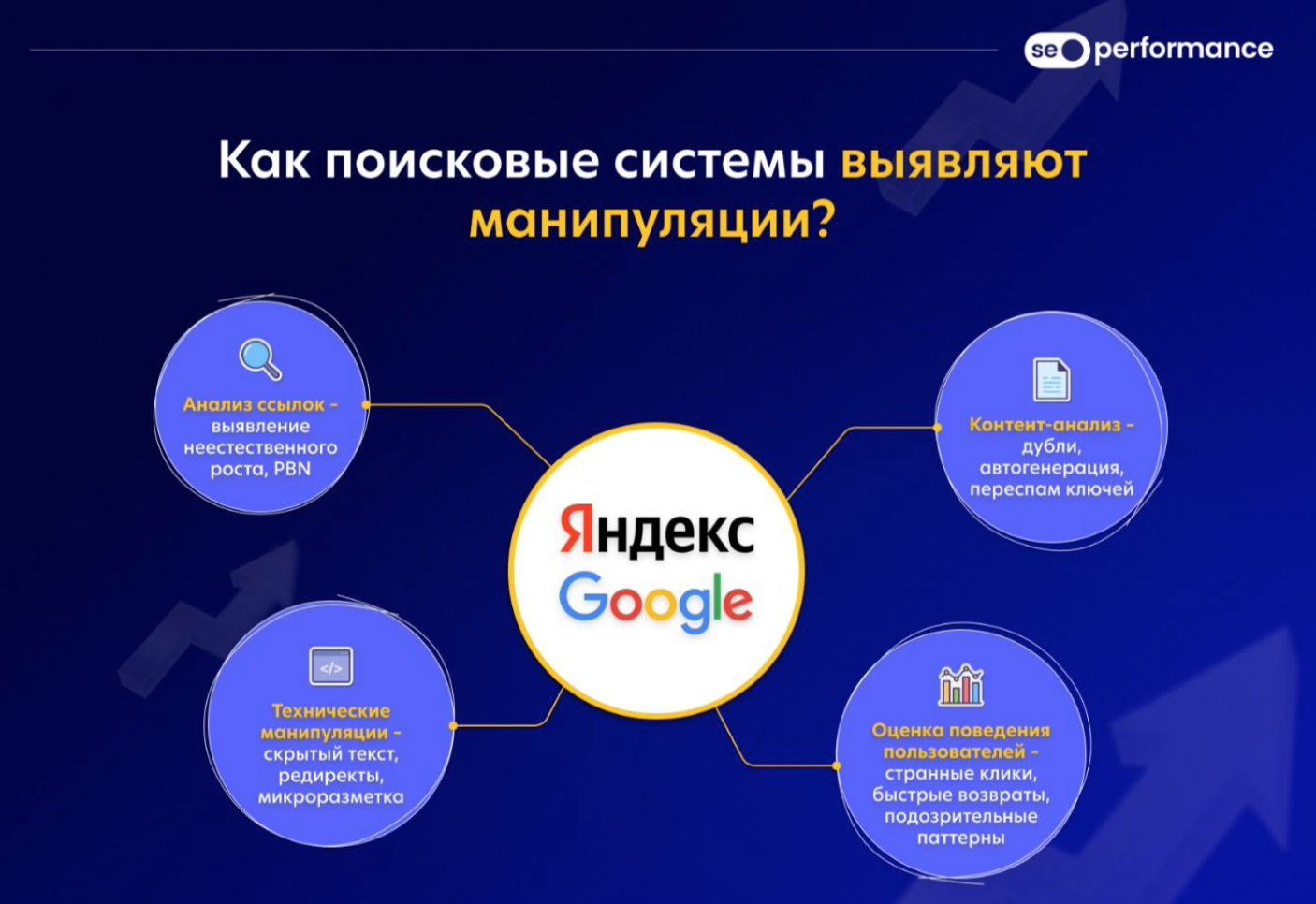

Как поисковые системы выявляют манипуляции?

Анализ ссылок. Выявление неестественного прироста ссылок, аномальных

Оценка поведения пользователей. Анализ взаимодействия пользователей с сайтом, времени на странице, глубины просмотров, возвратов к выдаче.

Выявление технических манипуляций. Использование скрытого текста, подмены контента (cloaking), редиректов, манипуляций с микроразметкой.

Алгоритмы боролись, борются и будут бороться с манипуляциями и в 2025 году. Однако серые методы при грамотном использовании могут давать и крутые результаты.

Почему в Google с этим строже, чем в Яндексе?

Google предъявляет более жёсткие требования к качеству контента и методам продвижения. Вот в чём это выражается:

Алгоритмы машинного обучения и ИИ. Google активно использует нейросетевые модели (BERT, MUM, RankBrain), которые анализируют естественность контента и выявляют признаки манипуляции. В Яндексе также есть алгоритмы машинного обучения (например, «Королёв»), но они менее агрессивны.

Жёсткие санкции за нарушение правил. Google применяет строгие меры, вплоть до полного исключения сайтов из индекса за использование запрещённых методов. В Яндексе штрафы не такие основательные, да и сайты чаще просто получают фильтры, а не тотальное удаление.

Анализ ссылочного профиля. В Google алгоритм Penguin распознаёт покупные ссылки,

Накрутка поведенческих факторов. В Яндексе манипуляции с поведенческими факторами (далее ПФ) долгое время работали и применялись для быстрого продвижения сайтов. Однако с 2023 года алгоритмы начали интенсивнее выявлять накрутку. В Google к тому времени такие методы стали вовсе практически бесполезны: система распознаёт искусственный трафик и игнорирует аномальные паттерны поведения. Тут уже единицы нашли обходные пути (мы, кстати, среди них).

В итоге жёсткие требования Google направлены на обеспечение высокого качества контента и естественного продвижения для владельцев сайтов и более релевантной выдачи у пользователей. Яндекс же, несмотря на менее агрессивные меры, постепенно догоняет в алгоритмах, особенно в нишах локального бизнеса и новостных порталах.

Как это влияет на использование серых методов?

-

В Google серые методы требуют более сложной маскировки и грамотного подхода. Использование PBN, накруток, скрытых редиректов и манипуляций с

анкор-листами может привести к санкциям. -

В Яндексе определённые серые тактики (накрутка ПФ,

крауд-ссылки ) работают, но с постепенным снижением эффективности, если халтурить на качестве стратегий. -

В обеих системах необходимо сочетание классического SEO (техническая оптимизация, контент, UX) с адаптацией под изменения алгоритмов, чтобы не провоцировать поисковики.

Таким образом, обе системы стремятся к улучшению качества выдачи, что делает выбор естественных методов продвижения наиболее безопасным и перспективным.

Самые популярные манипулятивные техники: работают ли они сегодня

Загадки, интриги, расследования… Какие

Чтобы избежать санкций, многие

Пройдёмся по механикам продвижения:

Закупка ссылок.

Метод: оплата размещения внешних ссылок на других сайтах.

Тип: серый.

Эффективность: всё ещё работает, но требует тщательной стратегии и качества ссылочной массы.

Как работает? Чем больше качественных ссылок ведёт на сайт, тем выше его авторитет в глазах поисковиков.

Как Google распознаёт? Неестественные

Методы обхода: качественные площадки, разбавленные анкоры, органичный рост ссылок.

Пользователи видят, что сайт имеет множество внешних рекомендаций, но при этом качество контента на нём может не соответствовать ожиданиям. Чтобы этого избежать и реально поднять сайт в выдаче, нужно соблюдать баланс и не создавать слишком искусственный ссылочный профиль.

Сетевые сайты (PBN).

Метод: использование сетей сайтов для передачи ссылочного веса.

Тип: серый.

Эффективность: уменьшается с каждым годом, но работает при правильной маскировке.

Как работают? Группа взаимосвязанных сайтов ссылается друг на друга, повышая вес главного проекта.

Риски: Google легко выявляет PBN, особенно с одинаковым контентом.

Методы обхода: разные IP, уникальные тексты, постепенное развитие сети.

Пользователи могут не заметить разницы, так как ссылки приходят с различных источников, однако качество самих сайтов часто страдает.

Вообще, эта техника способна временно повысить авторитет сайта за счёт искусственного создания ссылочной массы, что помогает улучшить позиции в поисковой выдаче при условии, что ссылки выглядят органично.

Поведенческие факторы.

Метод: искусственное улучшение показателей поведения пользователей.

Тип: серый.

Как работает? Оптимизаторы накручивают клики, просмотры, время на сайте, повторяя реальные действия пользователей на сайте.

Как Google борется? Искусственные паттерны поведения определяются алгоритмами машинного обучения.

Методы обхода: реальные люди вместо ботов, смешение органического и искусственного трафика.

Чтобы качество взаимодействия пользователя с сайтом не снижалось и сайт лучше ранжировался, важно не переборщить с накруткой.

Использование дроп-доменов .

Метод: перенос старого домена с хорошей историей на новый проект.

Тип: серый.

Как работает? Старые домены передают ссылочный вес новому сайту.

Как Google борется? Проверяет резкие изменения тематики и ссылочной массы.

Методы обхода: использование релевантных доменов, постепенное изменение структуры.

Передача ссылочного веса от старого домена позволяет новому сайту быстрее набрать авторитет и занять позиции в поисковой выдаче.

Подмена контента (Cloaking).

Метод: показ разного контента пользователям и поисковикам.

Тип: чёрный.

Как работает?

Как Google борется? Использует краулеров, которые сравнивают версии сайта.

Методы обхода: практически нет, метод практически не работает.

Метод создаёт ощущение обмана для всех, даже если он на время способен повысить позиции сайта. Ко всему прочему, риск санкций делает его крайне неэффективным в долгосрочной перспективе.

Линкбомбинг и накрутка анкор-листов .

Метод: массовая покупка ссылок с одинаковыми анкорами.

Тип: чёрный.

Как работает: если множество внешних сайтов ссылаются на ваш ресурс, используя важные ключевые слова, поисковики воспринимают это как признак релевантности вашего сайта и повышают его рейтинг.

Как Google борется? Фильтр Penguin наказывает за неестественные анкоры.

Методы обхода: разбавление брендированными и

Один момент: пользователи видят большое количество ссылок с повторяющимися анкорами, что говорит о низком качестве сайта. И это после того, как они впечатлились его высоким авторитетом. Впрочем, и риски санкций от ПС значительно перевешивают временные выгоды.

Использование ChatGPT и нейросетей для SEO.

Метод: автоматическая генерация контента с помощью искусственного интеллекта.

Тип: серый.

Как работает? AI создаёт статьи, которые затем публикуются для продвижения сайта.

Как Google борется? Выявляет шаблонные и неуникальные тексты.

Методы обхода: редактирование, добавление уникальных данных, совместная работа с экспертами (копирайтерами).

Чат GPT однозначно имеет потенциал в написании и достижении бОльших объёмов контента, но часто такой материал не способен раскрыть тему сполна. Многие вопросы пользователя без глубокого анализа темы так и остаются без ответов. Материал прежде всего должен быть адаптирован под реальные запросы пользователей.

Эти техники являются актуальными инструментами для продвижения сайтов в 2025 году, но к ним нужно подходить аккуратно и вдумчиво. Некоторые методы, такие как закупка ссылок и использование PBN, могут давать результаты при правильном использовании. Здесь нужно хорошо подумать над тем, как минимизировать риски. Манипуляции с ПФ и использование AI для генерации контента также могут повышать позиции сайта в выдаче, но при отсутствии качественной адаптации контента рискуют снизить доверие аудитории и поисковиков. Поэтому, если вы хотите добиться стабильного роста и качественного продвижения, важно использовать эти методы с осторожностью, комбинируя их с естественными способами оптимизации. Пробовать, экспериментировать — пожалуйста, но без ущерба для качества поисковой выдачи и пользователей.

Мифы о манипуляциях: что уже не работает?

Есть некоторые мифы, актуальность которых до сих пор обсуждается. Но давайте не будем тратить на их тест время, потому что они больше не работают.

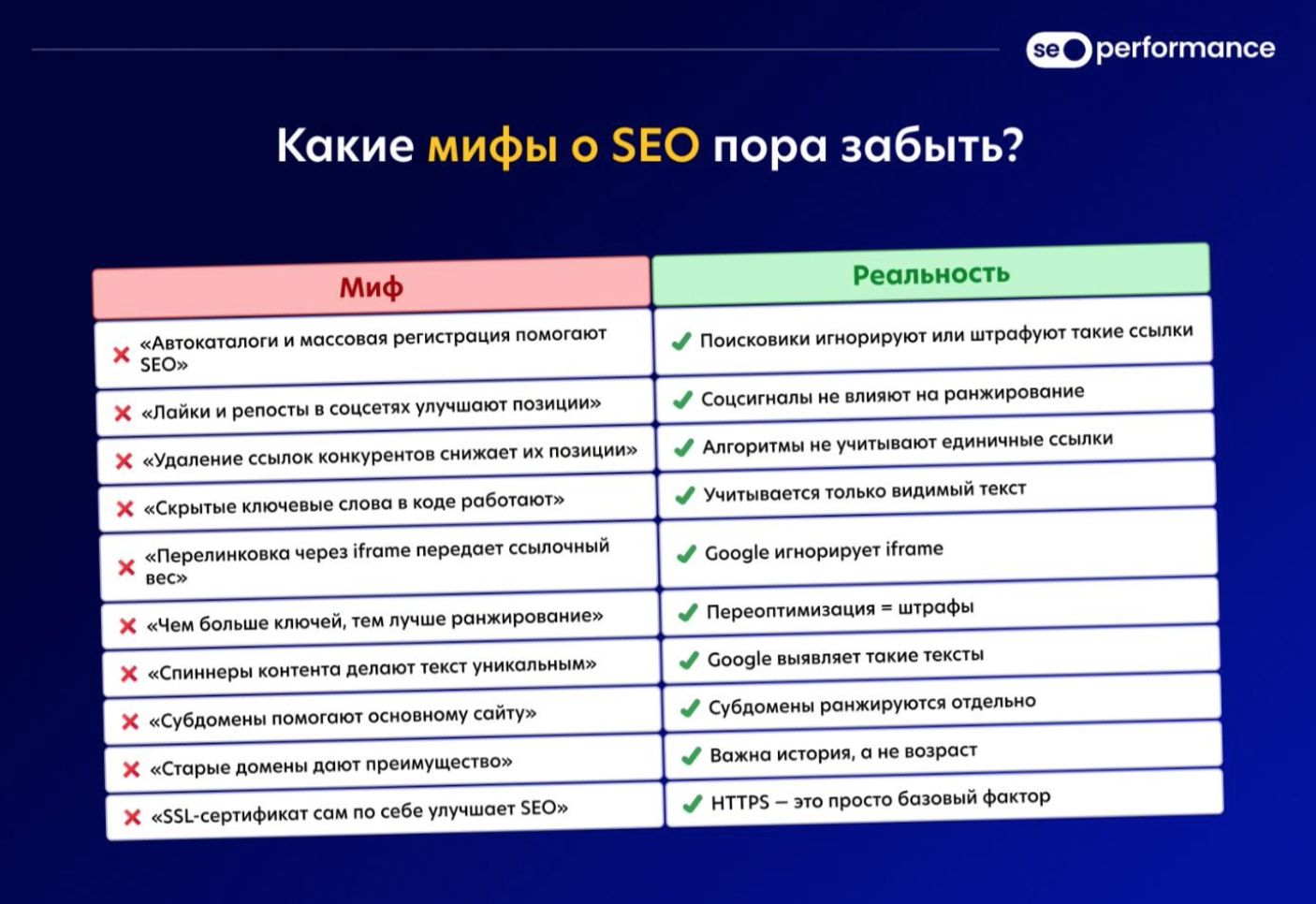

Миф 1: автоматические каталоги и массовая регистрация сайтов помогают SEO

Раньше многие сайты получали тысячи ссылок из автоматических каталогов и регистрировались на сотнях сервисов, чтобы увеличить ссылочную массу. Если раньше активная ссылка приводила потенциальных посетителей, сегодня Google и Яндекс научились распознавать подобные схемы: часть ссылок закрывается самими каталогами, либо сами каталоги попадают под фильтры поисковиков. Так, большинство из них либо закрыты, либо обесценены, а массовая регистрация может привести к бану.

Почему не работает?

-

Поисковые системы игнорируют большинство таких ссылок.

-

Ссылки с некачественных площадок могут ухудшить репутацию сайта.

-

Google Penguin банит за неестественное наращивание ссылочной массы.

Миф 2: накрутка лайков и репостов в соцсетях влияет на ранжирование

Многие до сих пор считают, что большое количество лайков и репостов в социальных сетях улучшает позиции сайта в поиске. Однако поисковые системы категорически не учитывают эти показатели.

Почему не работает?

-

Google и Яндекс не используют соцсигналы в качестве основного фактора ранжирования.

-

Боты и фейковые аккаунты не создают реальный трафик.

-

Соцсети работают по своим алгоритмам, и искусственная активность быстро выявляется.

Миф 3: удаление ссылок конкурентов ухудшает их позиции

Некоторые

Почему не работает?

-

Поисковые системы понимают, что ссылки могут удаляться не по вине владельца сайта.

-

Если ссылка была органичной, её удаление не повлияет на позиции конкурента.

-

Алгоритмы учитывают общий профиль ссылок, а не единичные изменения.

Миф 4: встраивание ключевых слов в код без отображения на странице

Раньше

Почему не работает?

-

Алгоритмы анализируют только отображаемый пользователям текст.

-

Google Penalization Algorithm штрафует за скрытый текст.

-

Такой метод может привести к пессимизации сайта.

Миф 5: перелинковка через iframe улучшает SEO

Iframe позволяет загружать контент с другого сайта, и некоторые

Почему не работает?

-

Поисковики не индексируют содержимое iframe как часть страницы.

-

Ссылочный вес не передаётся через встроенные фреймы.

-

Google приравнивает такие ссылки к внешним и игнорирует их в ранжировании.

Миф 6: чрезмерная плотность ключевых слов повышает релевантность страницы

Ранее тексты с высоким процентом ключевых слов хорошо ранжировались, но в приоритет встали интересы пользователя, для которого такой текст был нечитабельным. Сегодня алгоритмы анализируют естественность языка, а не количество вхождений ключей.

Почему не работает?

-

Алгоритмы Google (BERT, RankBrain) анализируют смысл текста, а не частоту слов.

-

Переоптимизированные страницы часто понижаются в выдаче.

-

Чрезмерное использование ключевых слов ухудшает читаемость текста.

Миф 7: генерация контента с помощью спиннеров даёт результат

Автоматические программы (спиннеры) создают «уникальные» тексты, переставляя слова и синонимизируя предложения.

Почему не работает?

-

Google Panda и другие алгоритмы определяют текст с плохой структурой и смыслом.

-

Такие тексты имеют низкую читабельность, что ухудшает ПФ.

-

Поисковые системы ценят уникальность не только на уровне слов, но и на смысловом уровне.

Миф 8: использование субдоменов повышает позиции основного сайта

Некоторые

Почему не работает?

-

Алгоритмы распознают такие схемы и ранжируют только один домен.

-

Субдомены конкурируют друг с другом, а не помогают основному сайту.

-

Такой подход увеличивает риск наложения санкций.

Миф 9: старые домены всегда дают преимущество

Считается, что возраст домена влияет на его позиции. Однако это не всегда так.

Почему не работает?

-

Важнее не возраст, а история домена.

-

Если домен долгое время был неактивен и не обновлялся, поисковики не учитывают его «возраст».

-

Дроп-домены без качественного контента не приносят пользы.

Миф 10: наличие SSL-сертификата автоматически улучшает SEO

Почему не работает?

-

HTTPS — один из сотен факторов ранжирования.

-

Без качественного контента SSL не поможет занять высокие позиции.

-

Главная ценность HTTPS — защита данных пользователей.

Вместо устаревших серых схем важно сосредоточиться на создании полезного контента, естественном наращивании ссылок, улучшении взаимодействия с пользователями и исследовании новых инструментов продвижения.

Чем грозит использование манипуляций

Основные угрозы, связанные с манипуляциями, включают фильтры, санкции, потерю позиций и трафика, а в худших случаях — полное исключение из поисковой выдачи.

Фильтры и штрафы Google и Яндекса

Поисковые системы используют целый ряд фильтров для выявления и последующего бана сайтов, явно манипулирующих выдачей:

-

Фильтр «Минусинск» (Яндекс) направлен против сайтов, использующих искусственное наращивание ссылочной массы.

-

Фильтр «Пингвин» (Google) — аналог Минусинска, который анализирует ссылочный профиль и выявляет манипулятивные стратегии, связанные с агрессивным линкбилдингом.

-

Фильтр за манипуляции поведенческими факторами. Еесли поисковая система обнаружит накрутку поведенческих метрик, ресурс может быть понижен в результатах поиска или даже исключен из индексации.

-

Фильтр «Песочница» (Google) применяется к новым сайтам, которые подозрительно быстро набирают трафик. Их продвижение искусственно ограничивается на несколько месяцев.

-

Алгоритм «Panda» (Google) анализирует качество контента, выявляя автоматически сгенерированные, неуникальные и бесполезные тексты.

-

Фильтр

«Баден-баден» (Яндекс) борется с переоптимизированными сайтами/страницами, контент которых бесполезен для пользователей. Этакий текстовый фильтр, чтобы обезопасить «уши» потенциальных клиентов.

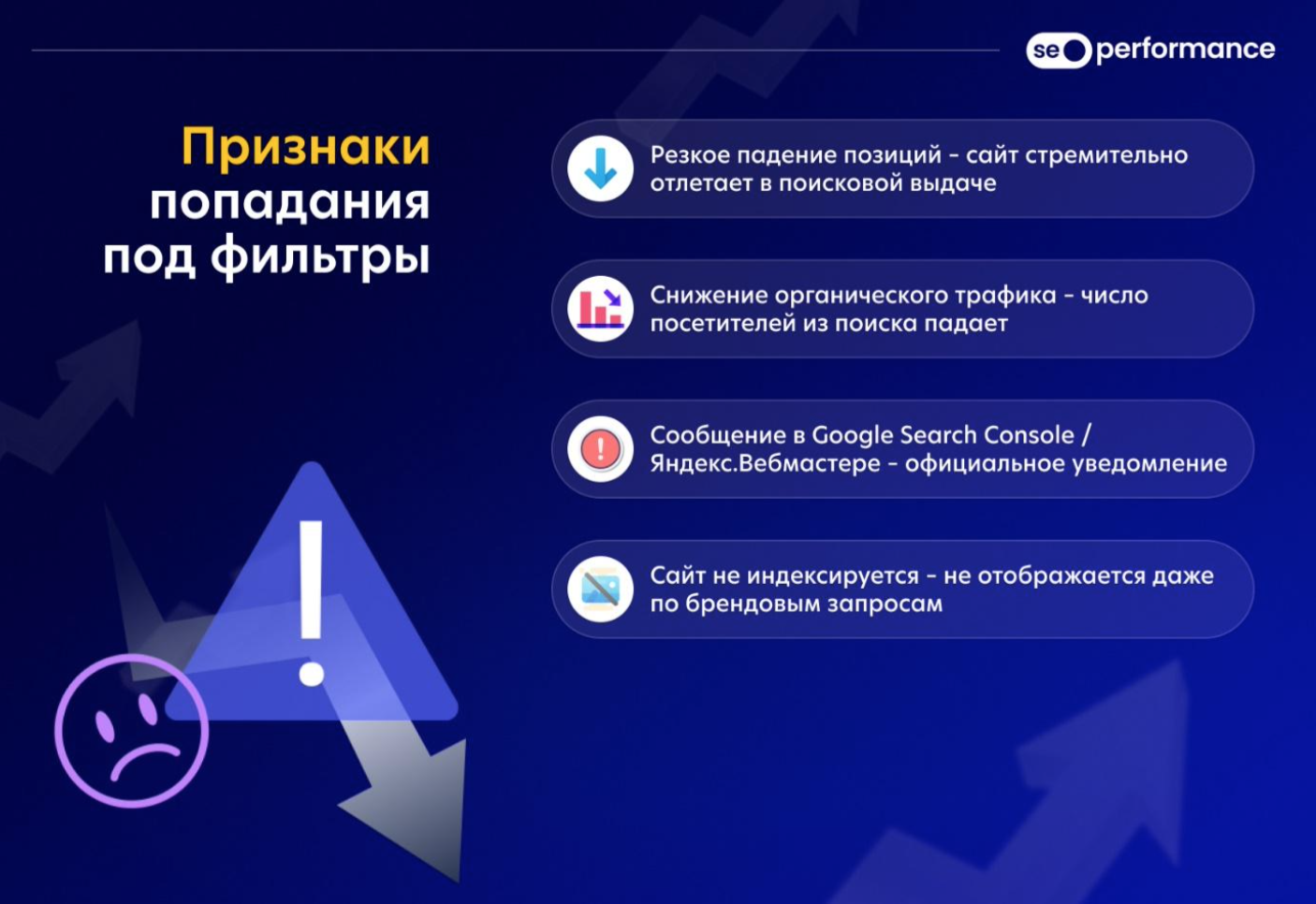

Как определить, что сайт попал под санкции?

Мы в Seo Performance Agency за годы практики сталкивались со всеми этими фильтрами и неоднократно. Признаки, указывающие на то, что сайт попал под фильтры поисковых систем, преимущественно идентичные. Вот они:

-

Резкое снижение позиций. Сайт неожиданно теряет позиции в поиске, несмотря на все предыдущие усилия по продвижению.

-

Снижение органического трафика. Количество пользователей, приходящих из поисковых систем, резко уменьшается.

-

Сообщения в Google Search Console и Яндекс Вебмастере. Официальные уведомления о нарушениях и наложенных санкциях.

-

Полное исключение из индексации. Сайт больше не отображается в поисковой выдаче даже по брендовым запросам.

-

Падение посещаемости после обновлений алгоритмов. После очередного апдейта поисковых систем сайт теряет трафик.

Можно ли вывести сайт из-под санкций?

Если сайт попал под фильтры, необходимо предпринять следующие шаги:

-

Анализировать ситуацию. Определить, какой именно фильтр наложен и за какие нарушения.

-

Удалить проблемные ссылки. Воспользоваться инструментами Google Disavow или Яндекс Вебмастера для отклонения некачественных ссылок.

-

Оптимизировать контент. Заменить низкокачественные или сгенерированные тексты на полезные и уникальные статьи.

Улучшить пользовательский опыт. Ускорить загрузку страниц, оптимизировать мобильную версию, повысить удобство навигации. -

Пересмотреть стратегию SEO. Отказаться от серых схем и сосредоточиться на белых методах продвижения.

-

Подать заявку на пересмотр. Если сайт полностью исправлен, можно обратиться в поддержку Google и Яндекса с просьбой о снятии санкций.

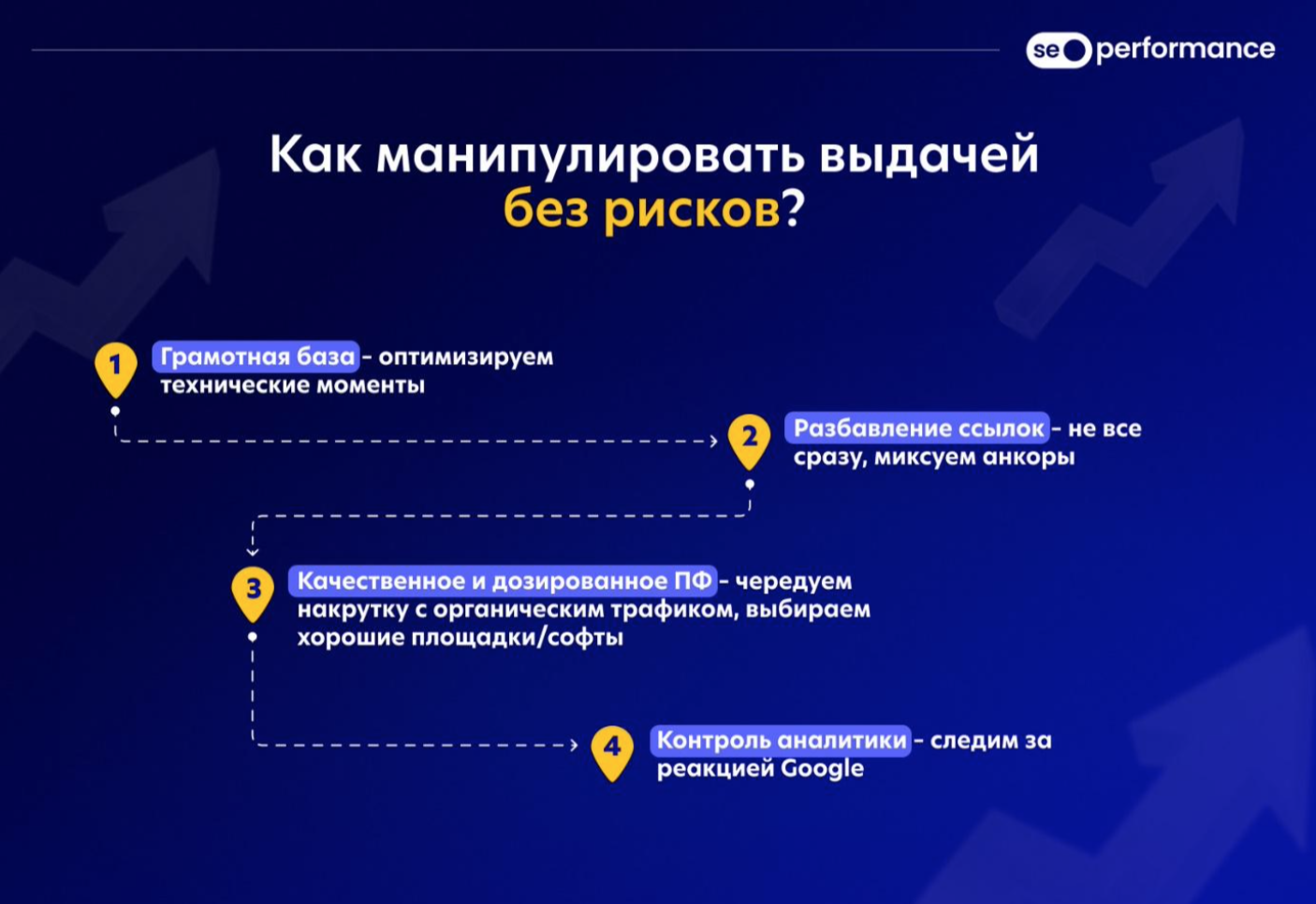

Как использовать серые методы без риска?

Использование серых методов в SEO требует тонкого подхода и понимания рисков.

Комбинирование белых и серых методов:

-

Основная

SEO-оптимизация . Перед использованием серых методов важно убедиться, что базовая оптимизация сайта соответствует требованиям поисковых систем. -

Маскировка ссылочных схем. Не стоит резко увеличивать количество ссылок или использовать однотипные анкоры. Необходимо размывать профиль, сочетая покупные ссылки с органическими, а также работать над естественным расширением ссылочной массы.

-

Умное управление поведенческими факторами. Не стоит рассчитывать только на накрутку кликов и посещений. Важно, чтобы пользователи действительно взаимодействовали с контентом, оставались на сайте, переходили по страницам и совершали целевые действия. Накрутка ПФ — это скорее инструмент стратегического роста, который не заменит базы (оптимизации).

Также важно постепенно внедрять серые методы продвижения, имитируя естественное развитие сайта.

Как минимизировать риски?

-

Разбавлять серые методы белыми техниками.

-

Постоянно следить за обновлениями алгоритмов Google и Яндекса.

-

Использовать аналитические инструменты, такие как Google Search Console, Яндекс Вебмастер, Google Analytics, Яндекс Метрика, SEMrush и Ahrefs для мониторинга позиций и поведенческих факторов.

-

Избегать спама и явных манипуляций, которые легко распознаются поисковиками. Да и пользователями, кстати, тоже.

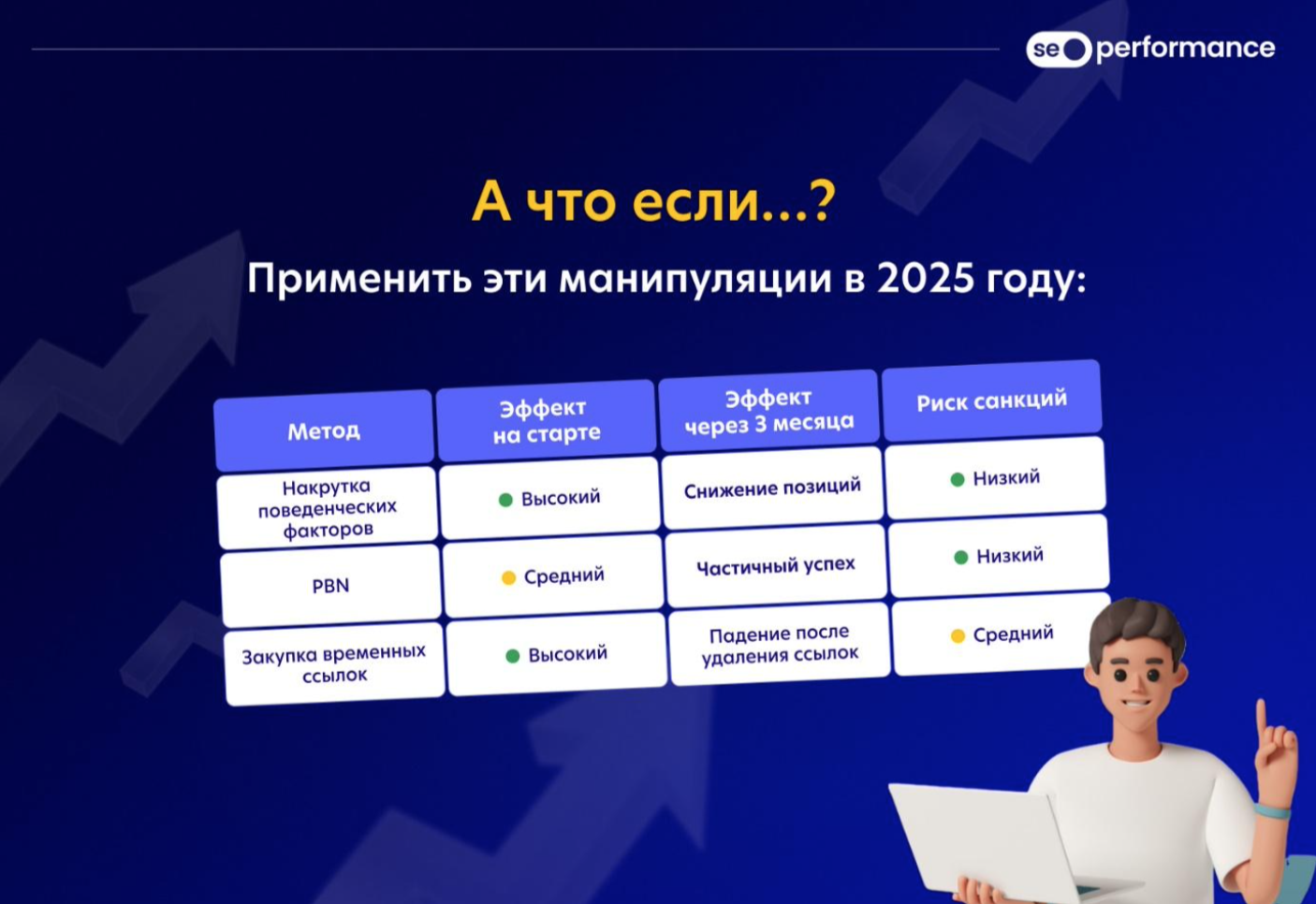

Практические кейсы: тестируем 3 манипулятивных техники

Недавно нами (Seo Performance Agency) был проведён

Метод 1: накрутка поведенческих факторов

Поисковики, в особенности Яндекс, уделяют всё больше внимания ПФ. Почему? Для всё той же персонализации поисковой выдачи. Теперь в оценке сайта гораздо большую роль играют ПФ, нежели ссылки. В Яндексе они вообще уже не работают.

Как реализовали? Через собственный софт:

-

Подобрали 100 ключей — возьмём их за 100% для подключения ПФ.

-

Применили сервисы, предоставляющие кликеров для имитации органического трафика.

-

Прогоняли трафик через VPN и разные устройства.

-

Создали эмуляцию естественного поведения: переходы по страницам, задержки на сайте, клики по кнопкам.

Результаты: за один день вывели сайт в

-

Топ-10 рост 21%-80%. -

Топ-5 рост 8%-65%. -

Топ-1 рост 0%-11%.

Итого:

-

Первый месяц. Рост позиций.

-

Второй месяц. Удержание позиций, но без дальнейшего роста.

-

Третий месяц. Постепенное снижение позиций после.

Вывод: накрутка поведенческих факторов может давать временный эффект, успех от которого можно повторять периодически. Также важно не останавливаться на одной стратегии, а постоянно тестировать различные гипотезы.

Метод 2: использование PBN (частные сетевые сайты)

Как реализовали?

-

Создали 15 сайтов с уникальным контентом.

-

Использовали разные хостинги и

IP-адреса . -

Постепенно наращивали ссылочную массу с этих сайтов на тестируемый ресурс.

Результаты

-

Первый месяц. Незначительный рост позиций (+3–7 позиций по среднечастотным запросам).

-

Второй месяц. Стабильный рост на +10–15 позиций, улучшение видимости сайта.

-

Третий месяц. Два сайта из PBN попали под фильтры, частичное снижение позиций основного ресурса.

Вывод: PBN остаётся рабочим инструментом, но требует высокой степени маскировки. При правильном подходе может приносить долгосрочные результаты, но при обнаружении схемы есть риск потери позиций.

Метод 3: закупка временных ссылок

Как реализовали?

-

Разместили 200 временных ссылок через биржи.

-

Использовали разбавленный

анкор-лист . -

Провели частичное естественное наращивание ссылочной массы.

Результаты

-

Первый месяц. Резкий рост позиций на 10–20 мест.

-

Второй месяц. Сохранение позиций, увеличение трафика.

-

Третий месяц. После удаления ссылок с биржи — падение на 30–50 позиций.

Вывод: закупка временных ссылок дает быстрый эффект, но без последующего закрепления результат не сохраняется. Использование временных ссылок без параллельного органического роста ссылочной массы рискованно.

Механики были проверены несколько раз для уверенности в их рабочих свойствах.

Накрутка ПФ и PBN оказались самыми стабильными методами, но требующими корректировок и осторожности. Временные ссылки дают быстрый эффект, но сопряжены с высокими рисками санкций, опять таки, при бездумном размещении.

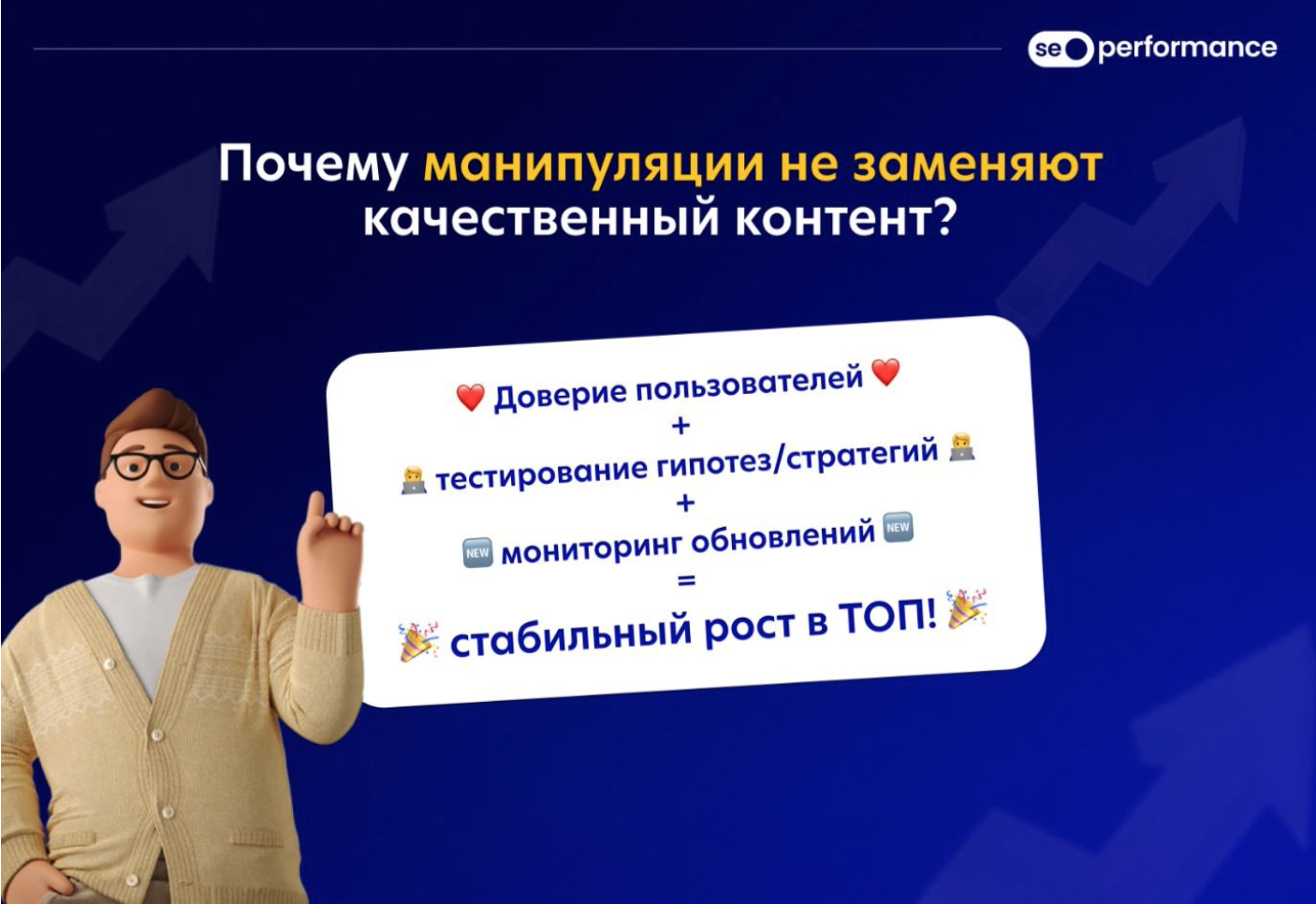

SEO — это постоянный баланс между риском и результатом

Лучшей стратегией остаётся комплексное продвижение, включающее качественный контент, естественное наращивание ссылочной массы и работу с поведенческими факторами. Инвестирование в долгосрочные тактики обеспечивает стабильный рост и защиту от возможных обновлений поисковых систем. А новые инструменты, в частности манипулятивные тактики, могут послужить драйвером и обновлением для привычной

Какие методы стоит использовать, а от каких лучше отказаться? Выбор зависит от целей и допустимого уровня риска. Важно помнить: чем больше сайт ориентирован на реальных пользователей, тем выше его шансы на успех в долгосрочной перспективе. Поэтому главное — строить стратегию продвижения с учётом качества контента, доверия аудитории и соответствия требованиям поисковых систем.

Мнение редакции может не совпадать с мнением автора. Ваши статьи присылайте нам на 42@cossa.ru. А наши требования к ним — вот тут.