Хотели сделать как лучше, а в итоге сломали SEO

Этот материал написан по мотивам подкаста «ИТАК». Послушать эпизод «SEO: частые ошибки в оптимизации сайтов и как их исправить» можно в «Яндекс Музыке» или Apple Podcasts.

Руководитель направления SEO в IT-Agency Юлия Кравченко рассказывает несколько антикейсов из практики команды, когда SEO ломалось там, где не ожидали. В конце материала она дала рекомендации, как избегать таких ситуаций, и несколько чек-листов для проверки сайта на соответствие требованиям SEO.

Внедрили определение региона по IP и потеряли 20 % поискового трафика

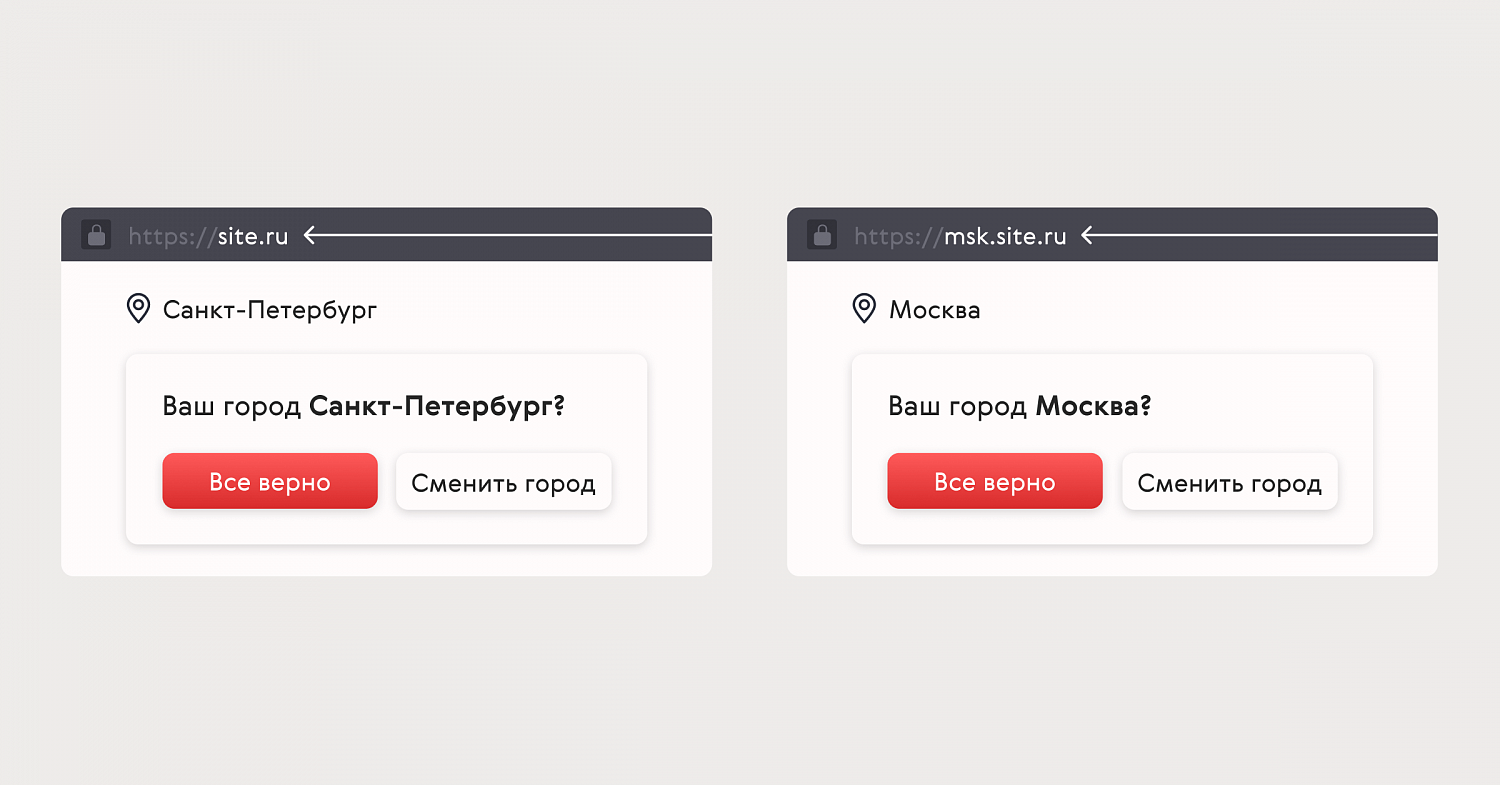

Этот антикейс связан с клиентом, бизнес которого сначала был представлен только в Санкт-Петербурге, а затем открылось представительство в Москве. И питерская, и московская аудитории посещали один сайт, с которым мы работали много лет.

Увеличить трафик из Москвы можно было за счёт создания сайта исключительно для этой аудитории. На основном домене решили внедрить автоматическое перенаправление пользователя, которое по IP определяло его регион и открывало соответствующую версию сайта. Если регион определялся как московский, то пользователя перенаправляло на поддомен.

Пользователям из Москвы открывалась версия сайта на поддомене

Мы даже предусмотрели, что на сайт заходят не только пользователи, но и поисковые роботы. Важно, чтобы для них весь контент сайта отображался как раньше — их не должно никуда перенаправлять. В противном случае робот исключает такие страницы из результатов поиска.

Нам казалось, что всё сделали корректно, но через несколько недель более ста страниц, которые приносили трафик, вылетели из индекса «Яндекса». Мы сразу стали искать причину и более вдумчиво читать «Справку».

Оказалось, что не учли одну небольшую деталь. Мы настроили исключения для роботов, которые приходят с адресов yandex.ru и yandex.com, но они приходили и с других доменов и поддоменов, которые мы не настроили. Например, все, кто приходил с сайта t5.yandex.ru, перенаправлялись на сайт для московской аудитории.

16 июля мы впервые заметили проблему и тут же всё исправили, но всё равно потеряли чуть больше 20 % поискового трафика и примерно такое же количество заявок из Санкт-Петербурга за месяц. Всё вернулось на круги своя только в середине августа.

Закрыли доступ к сайту по IP и вылетели из выдачи в Google

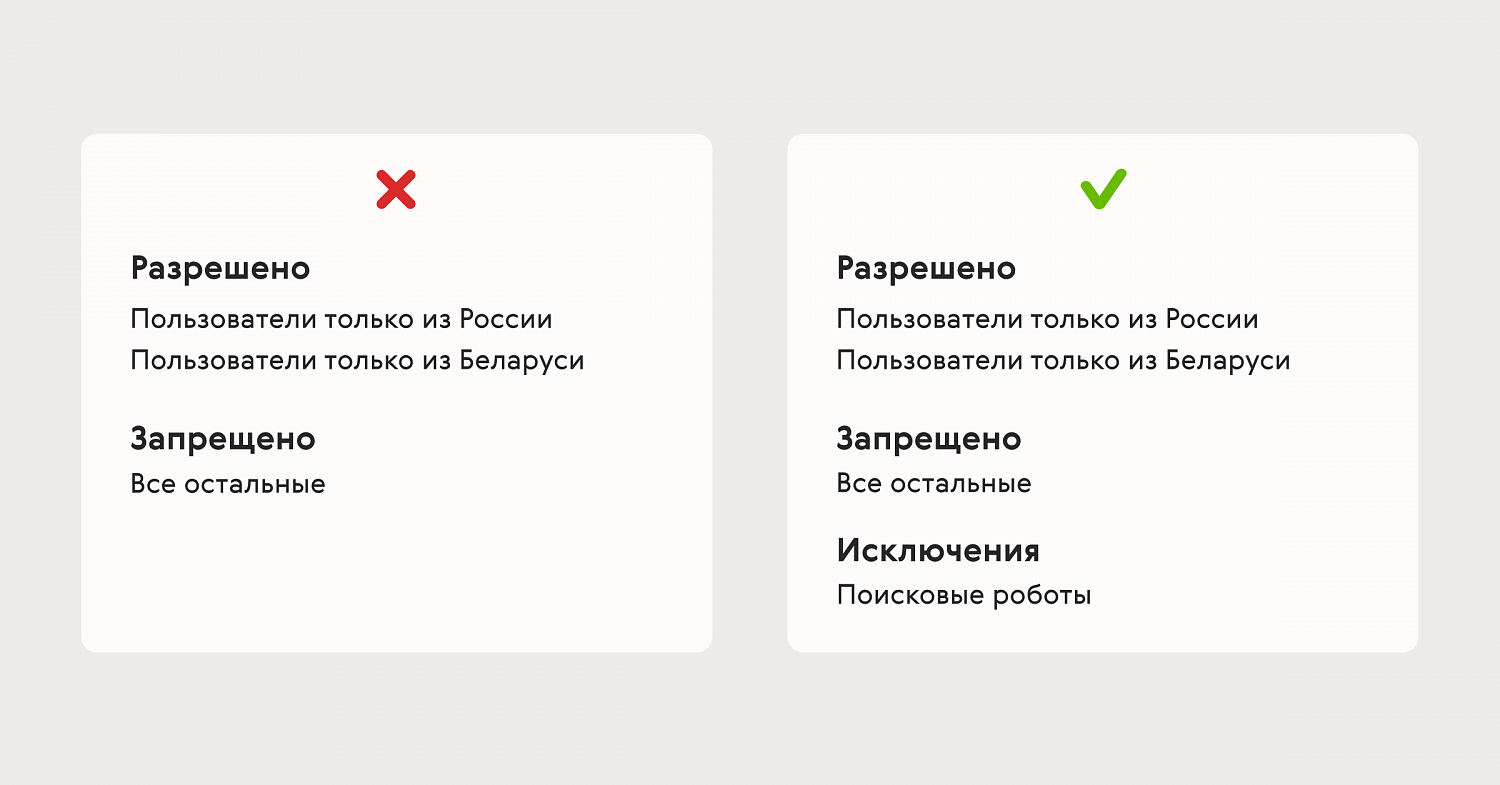

Второй антикейс тоже связан с темой исключений. После начала СВО многие компании обеспокоились вопросом безопасности. Они боялись, что сайты могут подвергнуться атаке или некоторые пользователи могут оставлять ложные заявки.

Внезапно в сервисе мониторинга позиций мы увидели, что у одного из клиентов все страницы сайта вылетели из результатов поиска в Google. Мы сильно удивились и стали выяснять, что произошло. В том числе спросили клиента про возможные технические работы на сайте, о которых мы не знали.

В компании была своя служба безопасности, которая рассказала, что закрыла доступ к сайту для всех, у кого IP были не из России или Беларуси. Нюанс в том, что поисковые роботы Google имеют зарубежные IP. Получается, такой блокировкой служба безопасности будто запретила ботам ходить на страницы сайта. Google увидел, что страницы недоступны, несколько раз попытался до них достучаться, а потом всё же исключил из индекса.

Если закрыть доступ к сайту по IP и не добавить в исключения поисковые роботы, можно потерять трафик

Ситуация была неприятная, потому что основной трафик на сайт шёл из Google. Если в обычное время посещаемость сайта составляла 7 000 человек в сутки, то из-за блокировки она упала до 1 500 человек в сутки.

Ситуация разрешилась так: мы нашли в документации Google список с названиями ботов, отправили его разработчикам клиента и попросили сделать исключения. А сами после внедрения отправили страницы на переобход роботами Google.

Посещаемость выросла через полторы недели. До прежних значений восстановить её не получилось, потому что на сайт по-прежнему могли заходить только пользователи из России и Беларуси. Но всё остальное, что потеряли из-за этой проблемы, мы вернули.

Сделали дубль страницы на поддомене и конкурировали сами с собой

Интересы команды SEO и других команд на проекте, например, продуктовых или технических, часто пересекаются. В таких ситуациях мы стараемся подружиться с другими командами,чтобы не отодвигать продуктовые предложения в пользу SEO и не отбрасывать SEO-рекомендации в угоду продуктовым идеям.

К сожалению, иногда случается так, что одна из сторон принимает какое-то решение без синхронизации или попытки найти компромиссный вариант с другой стороной. В моей практике есть эпизод, который связан с продуктовой командой клиента.

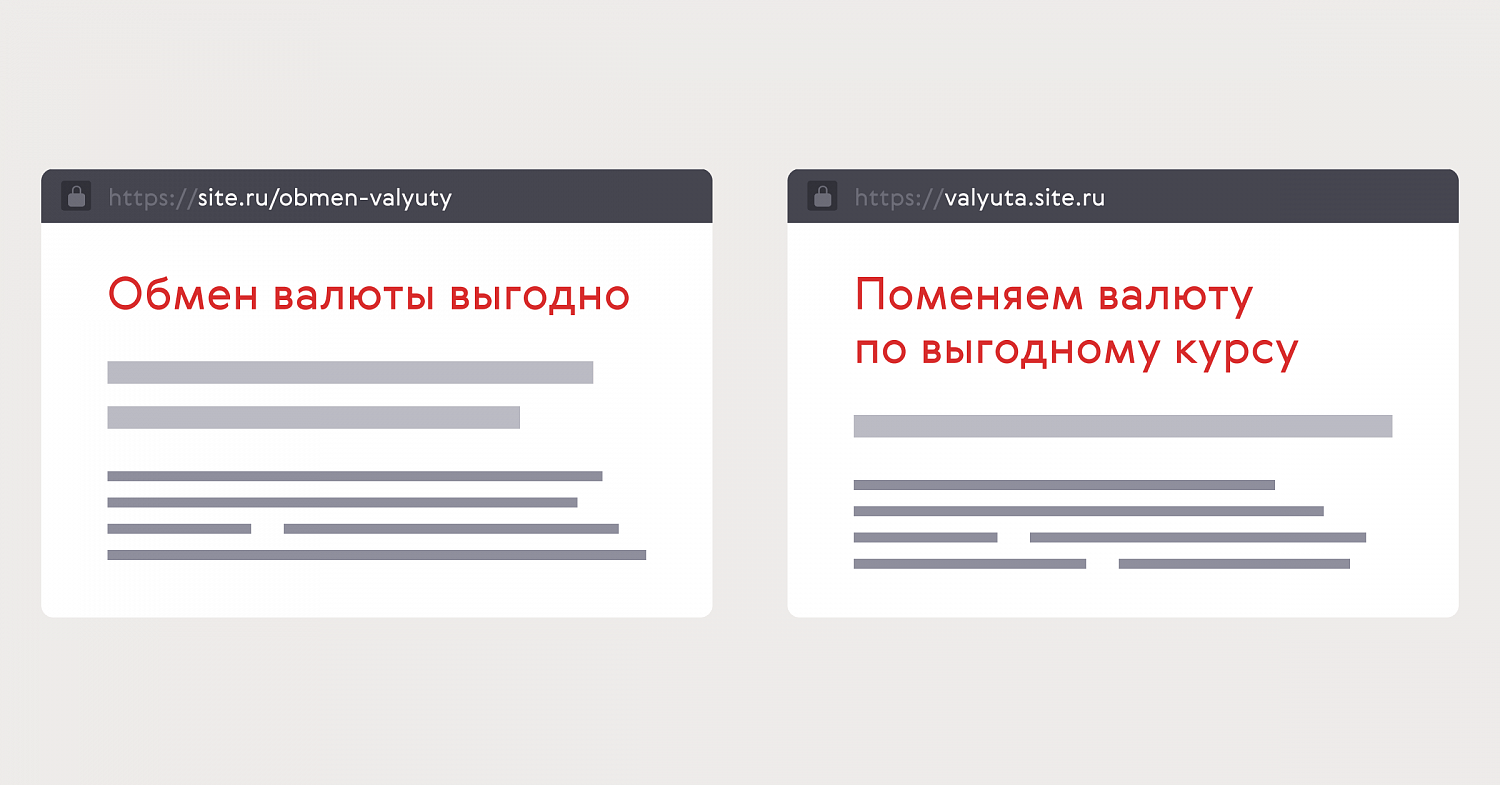

Есть основной сайт с отдельными страницами под услуги организации, которые показываются по своим целевым запросам в поисковой выдаче. Есть продуктовая команда, которая отвечает за развитие продуктов. У команды есть конверсионные метрики, связанные с количеством заявок на каждый продукт.

В какой-то момент ребята решают без синхронизации с нами сделать копию одной из страниц сайта на новом поддомене, а потом изменить там описание услуги.

Копия страницы на поддомене даже с другим текстом считается смысловым дублемс

С точки зрения SEO для поисковых роботов появились смысловые дубли — две страницы одной компании, на одном домене, которые отвечают на одни и те же запросы. Обе страницы индексируются, из-за чего роботам сложно решить, какая из них в большей мере отвечает на запросы пользователей. Из-за этого происходит так называемое «мигание» — страницы начинают конкурировать друг с другом в поисковой выдаче, чередоваться в показах.

Каждый раз такое «мигание» приводило к тому, что обе страницы показывались на более низких позициях, чем было до этого. Мы проанализировали результаты по трафику и конверсиям на обеих страницах, обсудили ситуацию с продуктовой командой клиента и решили закрыть от индексации страницу на поддомене.

Автоматизировали создание страниц в интернет-магазине, но потеряли позиции

SEO можно «убить», когда удаляешь что-то нужное или добавляешь что-то ненужное. Ещё можно добавить что-то нужное и всё равно «убить» SEO, если не предусмотреть возможные последствия. Так и вышло, когда решили ускорить выпуск новых страничек в интернет-магазине с огромным ассортиментом товаров.

Каждый товар имеет набор характеристик и может одновременно находиться как в основном каталоге, так и в смежных — например, в каталоге по производителям. Такой большой интернет-магазин будет хорошо ранжироваться в поисковой выдаче, если на сайте есть все целевые страницы и все целевые разделы, которые отвечают на конкретные запросы конечного пользователя. Например, для группы запросов «купить телевизор» должна быть отдельная страница только с телевизорами, а не с телевизорами, роутерами, ноутбуками и телефонами.

Мы хотели привлекать на сайт весь целевой трафик. Для этого нужно было быстро получить большое количество новых страниц. Каждая из них отвечала бы на свои запросы и была потенциальным источником трафика с поиска. Мы решили автоматизировать создание таких страниц при пересечении характеристик товаров. Однако лучшее — враг хорошего. Мы не предусмотрели, что такой способ может генерировать большое количество дублей, раз у нас есть несколько параллельных разделов для товаров.

Объясню на примере. В основном каталоге есть раздел с телевизорами. У каждой модели есть характеристики: производитель, цвет, диагональ и так далее. Внутри раздела с телевизорами может быть создана подборка только с моделями от Samsung — это будет отдельная страница с уникальным адресом.

Параллельно на сайте есть раздел каталога с брендами производителей, из которого пользователь может перейти в товарную группу. Сначала пользователь заходит в раздел Samsung, а уже оттуда переходит в раздел «Телевизоры Samsung».

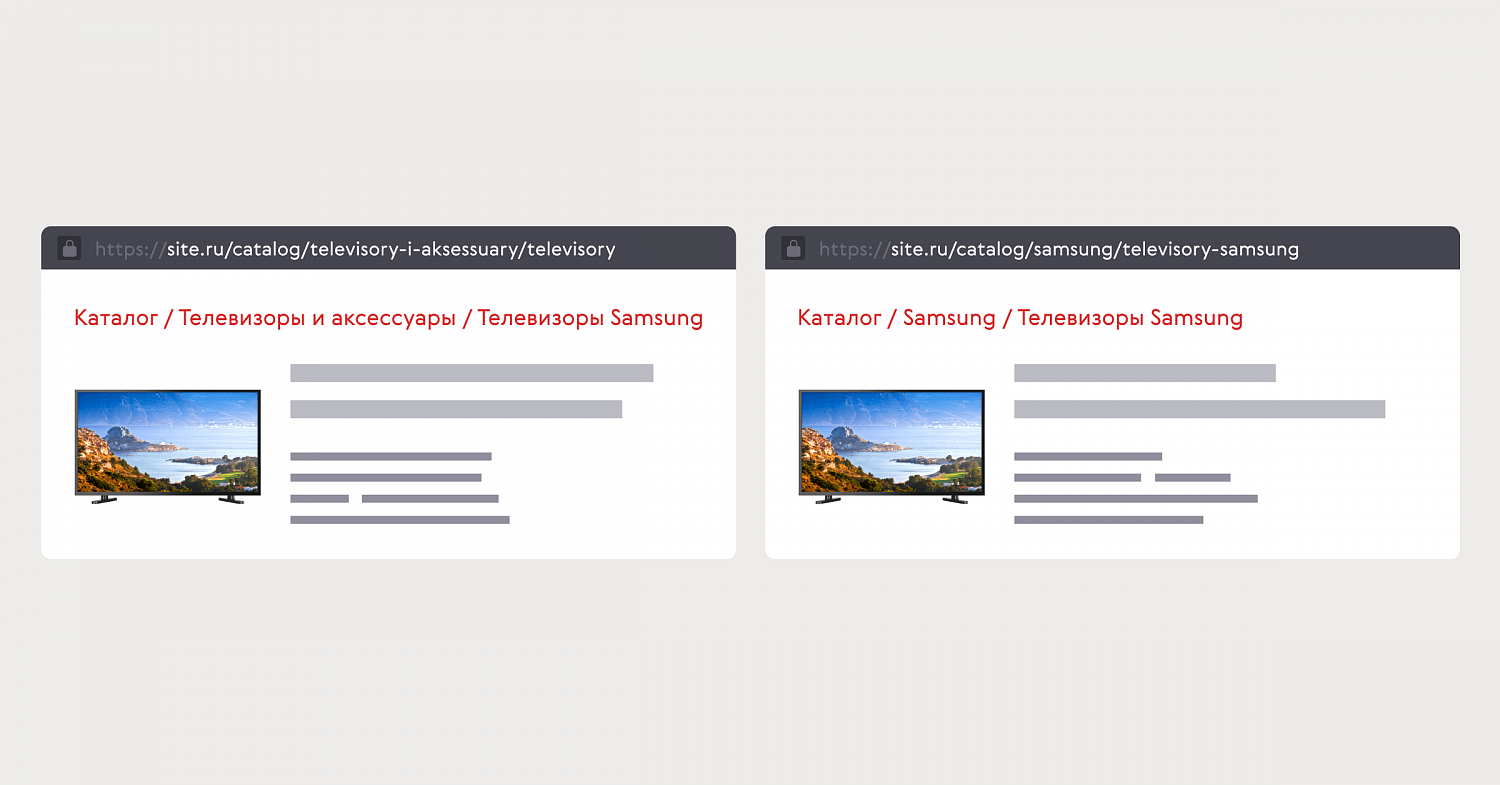

Одинаковые подборки товаров с разными адресами страниц — тоже смысловой дубль с точки зрения SEO

В нашем случае получилось, что в обоих разделах создавались подборки по одной и той же характеристике, с одинаковыми товарами, но разными адресами страниц. Для поисковых систем это 100 % дубли, как в предыдущей истории.

В достаточно неплохом сценарии можно удалить все дубли и оставить одну страницу, которую поисковые системы признают основной и будут ранжировать её в поисковой выдаче. В худшем случае, как было у нас, началось «мигание» — страницы стали конкурировать друг с другом, а иногда исключались из индекса.

Ситуацию ухудшало то, что некоторые страницы, созданные автоматически, были не просто дублями, но и содержали малополезный контент. Например, встречались страницы с одним-двумя товарами, которые после продажи пропадали с сайта и страницы оставались пустыми. Растущий объём страниц с малополезным контентом негативно отражался на рейтинге всего сайта и снижал позиции в поисковой выдаче.

С одной стороны, автоматическое создание страниц на основе характеристик товаров — это быстро и удобно. Крупные сайты могут реализовать массовые решения и достаточно быстро увидеть результат. С другой стороны, если не предусмотреть все возможные последствия, то этот инструмент может стать своеобразной красной кнопкой, которая либо ухудшит, либо разрушит результаты, которые нарабатывались годами.

После произошедшего мы полностью отказались от идеи автоматизации создания страниц на этом проекте. Оставили только те страницы и разделы, которые создали в рамках основного каталога. Страницы из параллельных каталогов, которые дублировались по смыслу и содержанию, мы закрыли от индексации поисковыми роботами или настроили редирект на страницы основного каталога.

Страницы с малополезным контентом мы тоже закрыли, но изменили подход к их созданию. Теперь, если хотим создать новый раздел, то проверяем, действительно ли такая подборка будет полезной для целевой аудитории. Для этого анализируем товары на сайте, спрос на них, а также оцениваем специфику товара и сравниваем с конкурентами. Например, если это специфический товар, который существует в 1–2 экземплярах и есть в каталоге у конкурентов, то можем создать с ним раздел. Если же в категории нет товаров или их недостаточно, это не всегда говорит о том, что с ней не нужно работать. Возможно, это потенциальная точка роста для бизнеса — в будущем можно масштабировать ассортимент и товарные группы.

Как можно избежать проблем с SEO

SEO — это синергия как минимум трёх сторон:

- Клиента, который отвечает за конечный результат.

- Поисковой системы, которая диктует свои правила, чтобы сайт чувствовал себя хорошо.

- SEO-эксперта, который пытается синхронизировать и подружить две предыдущие стороны.

Из этого вытекает первая рекомендация — синхронизируйтесь. Важно, чтобы все стороны одинаково понимали цели и действовали сообща, чтобы быстрее и эффективнее к ним двигаться. Для этого как минимум все должны быть в курсе глобальных изменений на сайте, а как максимум — участвовать в их обсуждении. Тогда каждая из сторон в рамках своей экспертизы сможет предусмотреть возможные последствия и продумать, как их не допустить и минимизировать риски.

Синхронизироваться — это находить компромиссные решения, которые позволят и решение внедрить, и не поломать у других сторон планы, цели, обещания, работу внутренних сервисов.

Сообщать другим командам нужно не только о масштабных изменениях из разряда «закрыть чужим айпишникам доступ к сайту», но и о тех, которые могут казаться незначимыми. Например, как в случае с созданием копии страницы на поддомене, пусть даже с другим содержанием.Только при тесном взаимодействии команд по SEO, продукту, технических команд и бизнеса в целом можно быстро и эффективно достигать цели и ничего не терять по пути.

Тестируйте глобальные решения небольшими итерациями. Этот вывод мы сделали после истории с автоматизацией интернет-магазина. Ограниченные выборки товаров помогают замерить эффект и выйти на возможные ошибки и негативные последствия, которые на старте работ были неочевидны. Теперь мы стараемся выбирать для тестов такие разделы, где ухудшения в SEO не повлияют сильно на ключевые метрики, но мы получим необходимую выборку и сможем оценить результат.

Отталкивайтесь от текущей задачи. Формат работы с агентством по SEO может быть разным. Если нужно решить понятную, конкретную задачу, например, сделать редизайн сайта, агентство поможет сопроводить этот процесс таким образом, чтобы ничего не потерять.

Если в компании уже работает какая-то SEO-команда или инхаус-специалисты, агентство с помощью аудита поможет понять, насколько эффективно они это делают и в ту ли сторону движутся.

Если цель более амбициозная, например, увеличить продажи за год в три раза, то работа агентства начинается с понимания точки А — где на текущий момент находятся сайт, клиент и его бизнес.

Мы, например, сначала оцениваем общее «здоровье» сайта, чтобы корректно расставить приоритеты и сформировать оптимальную и эффективную стратегию продвижения для бизнеса с учётом его целей и потребностей.

На этом этапе мы используем базовые чек-листы оценки технического состояния сайта, его удобства, соответствия поисковым запросам и базовым требованиям поисковых систем. По итогам проверки отмечаем сильные и слабые стороны проекта и разрабатываем стратегию — каким путём из точки А прийти к цели.

Вы тоже можете использовать эти чек-листы, чтобы самостоятельно проверить, отвечает ли ваш сайт важным требованиям поисковых систем. В нашем файле вы найдёте три вкладки для проверки оптимизации: техническая, постраничная и коммерческая. Скопируйте его на свой Google Диск с помощью меню «Файл → Создать копию», чтобы он всегда был под рукой. Если же решите доверить это экспертам, у вас как минимум будет понимание, что и на каком этапе будет происходить.

Впервые статья была опубликована в Академии IT-Agency, где можно изучить другие материалы об интернет-маркетинге, SEO, CRM, а также управлении, аналитике и устройстве агентства.