Статистическая значимость и ошибки в A/B тестах

A/B тесты — это популярный способ маркетингового исследования, суть которого заключается в том, что респонденту предлагают оценить несколько немного отличающихся образцов для того, чтобы выявить наиболее удачный вариант продукта.

Cossa.ru представляет вашему вниманию перевод текста Кинида Боулса (Cennydd Bowles), дизайнера digital продуктов из Лондона, о том, как опасно дизайнеру полагаться на количественные исследования, и, в частности, A/B тесты результатов своей работы.

На прошлой неделе я подбросил монету сто раз подряд. 49 раз выпала решка. Потом я переоделся в красную футболку и подбросил монету ещё сто раз. 51 раз — решка. Из этого я заключаю, что подбрасывание монеты в красной футболке увеличивает шанс выпадения решки на 4,1%.

Примерно так же смешны, как этот вывод, бывают результаты анализа в A/B тестированиях, когда пользователю предлагается выбрать из двух вариантов предпочтительный.

Это логично и похвально, когда дизайнеры в своей работе пытаются думать, помимо прочего, о конверсии и ROI, но главное не переусердствовать.

Эффективная реклама с кешбэком 100%

Таргетированная реклама, которая работает на тебя!

Размещай ее в различных каналах, находи свою аудиторию и получай кешбэк 100% за запуск рекламы.

Подключи сервис от МегаФона, чтобы привлекать еще больше клиентов.

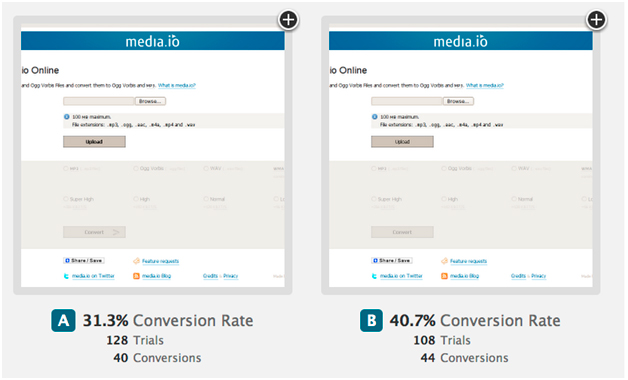

Рассмотрим пример от ABTests.com:

Эти две версии немного отличаются.

В версии А подписи кнопок Upload и Convert выполнены жирным шрифтом, а также у кнопки Convert есть стрелочка.

В версии B жирный шрифт для подписей не используется, и стрелочки нет.

Несмотря на то, что незначительные изменения подчас могут повлечь за собой серьёзные последствия, я не предполагал, что столь мелкие различия могут сильно влиять на юзабилити. Пожалуй, я мог предположить, что версия А была бы эффективнее версии B, так как жирный шрифт в ней — это призыв к действию.

Дизайнер, однако, опроверг все мои предположения: оказалось, что у версии B при сравнительном тесте конверсия была на 30,4% выше.

Впрочем, на этот счёт у меня есть несколько замечаний.

Любой A/B тест — это эксперимент. Мы никогда не можем знать заранее, какой дизайн повышает конверсию. Мы можем только управлять экспериментом, получать эмпирические данные, на основании которых приходить к заключению: является ли новый дизайн улучшением или нет.

Чтобы быть достоверным, эксперимент должен быть продолжительным. В понедельник конверсия может составлять 27,5%, во вторник — 31,3%, а в среду — 26%, поэтому для того, чтобы делать вывод, необходимо произвести наблюдение объекта во времени.

В статистике часто используется нулевая гипотеза («различия между конверсией А и В вызваны случайным изменением»). Эксперимент в таком случае направлен на то, чтобы опровергнуть это положение. Чтобы определить, можем ли мы отклонить нулевую гипотезу, потребуются математические уравнения для вычисления вероятности того, что наблюдаемое явление случайно. Например, это, это или вот это.

Если арифметика показывает, что вероятность случайности мала (ниже 5%), нулевую гипотезу можно отвергать.

Основной проблемой A/B тестов является, как правило, малый размер выборки. В рассматриваемом нами случае — 128 и 108 пользователей соответственно. Этого недостаточно. С данными образцами желательно провести эксперимент с участием, как минимум, вдвое большего числа пользователей.

Ещё одна проблема тестов в том, что они говорят нам, какова ситуация, но не говорят, почему. Для того, чтобы получить ответ на этот вопрос, нужны либо эксперименты, подразумевающие качественные оценки, либо сравнение множества слегка различающихся вариантов между собой.

Диалог между дизайнером и заказчиком в этом случае происходит примерно следующий:

Дизайнер: Вот новый дизайн продукта — изменилась навигация, выбрана оптимальная цветовая палитра, изменился алгоритм взаимодействия с вкладками.

Заказчик: Это довольно большие изменения, давайте проверим каждое из них по отдельности, чтобы посмотреть, что сработает, а что нет.

Предложенный заказчиком способ — то же самое, что попытка вместо одного большого прыжка через пропасть совершить несколько маленьких. Постепенно внедряя лишь те элементы, которые прошли апробацию в результате A/B теста, вы, возможно, заработаете чуть больше денег, однако дизайн интерфейса вашего продукта станет фрагментированным и непоследовательным. В долгосрочной перспективе от этого больше вреда, чем пользы.

Я обеспокоен той наивностью, с которой некоторые дизайнеры подходят к количественным методам тестирования. Статистика не терпит дилетантизма, поэтому прежде, чем делать уверенные выводы, стоит посерьёзнее изучить научные основы.

Источник: cennydd.co.uk